如何快速全面建立自己的大数据知识体系

大数据技术已经成为现代企业和研究机构不可或缺的核心竞争力。对于想要进入这一领域的学习者来说,建立一个系统化的大数据知识体系至关重要。本文将从基础概念、技术栈、学习路径和实践方法四个维度,帮助你快速全面地构建自己的大数据知识体系。

一、理解大数据基础概念

大数据不仅仅是数据量大的问题,其核心特征可以用“5V”概括:

- Volume(数据量):TB、PB级别的数据规模

- Velocity(速度):数据产生和处理的实时性要求

- Variety(多样性):结构化、半结构化和非结构化数据

- Veracity(准确性):数据质量和可信度

- Value(价值):从数据中提取商业价值

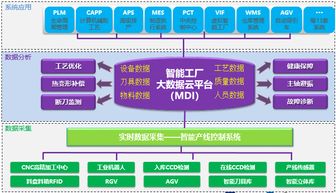

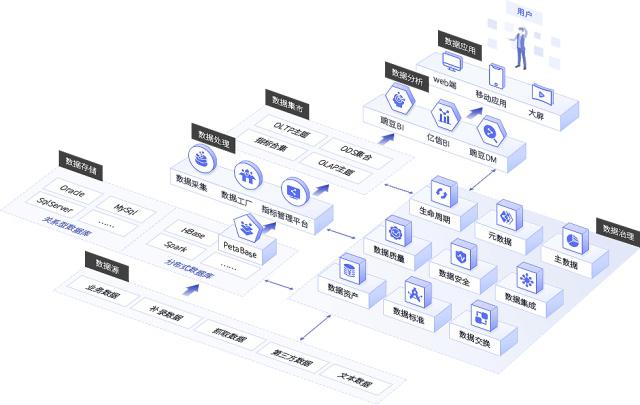

二、掌握核心大数据技术栈

现代大数据技术体系主要包含以下几个关键层次:

- 数据采集层

- 日志收集:Flume、Logstash

- 消息队列:Kafka、RabbitMQ

- 数据库同步:Canal、Debezium

- 数据存储层

- 分布式文件系统:HDFS

- NoSQL数据库:HBase、Cassandra、MongoDB

- 数据仓库:Hive、ClickHouse

- 云存储:AWS S3、阿里云OSS

- 数据处理层

- 批处理:MapReduce、Spark Core

- 流处理:Spark Streaming、Flink

- 图计算:GraphX、Giraph

- 数据计算层

- 查询引擎:Presto、Impala

- 机器学习:Spark MLlib、TensorFlow

- 资源管理:YARN、Kubernetes

- 数据应用层

- 数据可视化:Superset、Grafana

- 任务调度:Airflow、DolphinScheduler

- 数据治理:Atlas、DataHub

三、规划学习路径

建议按照以下四个阶段循序渐进:

阶段一:基础入门(1-2个月)

- 学习Linux基础命令和Shell脚本

- 理解分布式系统基本原理

- 掌握Java或Scala编程语言基础

- 学习SQL语法和数据库基础知识

阶段二:核心技术(3-4个月)

- 搭建Hadoop集群环境

- 深入学习HDFS、MapReduce、YARN

- 掌握Hive数据仓库技术

- 学习Spark核心概念和编程

阶段三:进阶扩展(2-3个月)

- 学习流处理技术:Kafka、Flink

- 掌握NoSQL数据库:HBase、Redis

- 了解数据湖和数据仓库架构

- 学习数据治理和质量管控

阶段四:实战应用(持续)

- 参与实际大数据项目

- 学习云平台大数据服务

- 关注行业最佳实践

- 持续学习新技术发展

四、实践方法与学习建议

- 动手实践是关键

- 在个人电脑上搭建伪分布式环境

- 使用云服务商提供的免费试用资源

- 参与开源项目的贡献和学习

- 构建项目组合

- 从简单的ETL流程开始

- 实现日志分析系统

- 构建用户行为分析平台

- 尝试实时数据处理项目

- 持续学习与交流

- 关注技术社区和博客

- 参加技术 meetup 和会议

- 加入开源社区讨论

- 阅读经典论文和技术文档

- 考取相关认证

- Cloudera认证专家

- AWS大数据专项认证

- 阿里云大数据工程师认证

五、总结

建立大数据知识体系是一个循序渐进的过程,需要理论基础与实践经验相结合。建议保持学习的系统性和持续性,从基础概念出发,逐步深入到具体技术实现,最后通过实际项目巩固知识。随着技术的不断发展,还需要保持对新技术的敏感度和学习热情。通过这样的系统化学习,你将能够建立起扎实的大数据知识体系,为职业发展奠定坚实基础。

如若转载,请注明出处:http://www.daowhy.com/product/183.html

更新时间:2026-02-23 05:56:23